Los circuitos integrados son los elementos más importantes y complejos de cualquier ordenador. En ellos se materializan los procesadores, GPUs, memorias RAM, SSDs y un largo etcétera.

Y su vida útil está disminuyendo por varios factores. A muchos os vendrá a la cabeza efectos como la electromigración o los cambios de tamaño físico debidos a las variaciones de temperatura. Sobre el primer fenómeno, consiste en el desplazamiento de átomos dentro del semiconductor debido a la corriente de electrones, lo cual puede provocar roturas físicas de algunas partes del chip como cables. En realidad esto ha sucedido siempre en todos los conductores y semiconductores por los que circula una corriente eléctrica pero no fue hasta principios de los 90s cuando se empezó a convertir en un problema. Y es que la miniaturización de la electrónica ha acentuado este efecto ya que a menor sección del semi/conductor, más probabilidades hay de que el desplazamiento de un solo átomo afecte al funcionamiento del circuito. Recordemos que los defectos físicos se ven acentuados con la temperatura.

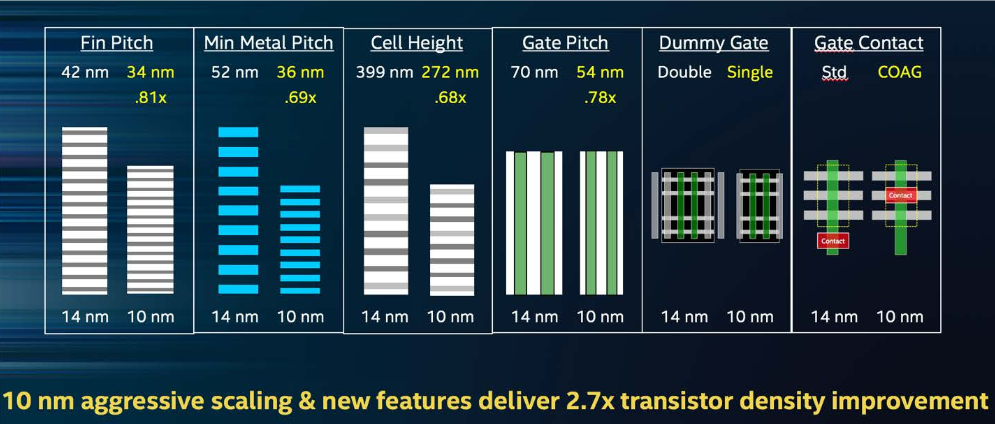

Pero también es verdad que los límites físicos llevan tiempo impidiendo el avance en este sentido y bajar de los 10nm (incluso llegar a ellos), está siendo un reto para los principales fabricantes de semiconductores. De esa forma, debe haber otras razones por las que se pueda hacer dicha afirmación: que los CIs envejecen cada vez más rápido.

A parte de los cambios físicos, en los últimos años ha habido un cambio de tendencia en el uso de lo ordenadores y ese cambio está relacionado con el tiempo de reposo. Hace sólo 15 años, los servidores tenían un tiempo de CPU de 5-15% del total disponible. Eso era así porque la energía era mucho más barata y el consumo de los servicios auxiliares (fuentes de alimentación, refrigeración, potencias de reposo, etc) era asumible. Desde que la energía se empezó a encarecer hace una década, se han aplicado algunos cambios en el uso de los recursos de hardware y de esos cambios, el más relevante ha sido la popularización de la «nube».

Antes era habitual que un servidor estuviera dedicado a una tarea en concreto y por eso su tiempo de reposo era del 85-95%: estaba casi todo el tiempo a la espera de recibir trabajo. Hoy en día, la virtualización ha hecho que las cargas de trabajo se puedan distribuir e intercambiar entre varias máquinas, por lo que ese tiempo de reposo ha disminuido considerablemente. Ahora un solo servidor ofrece tiempo de proceso a infinidad de servicios lo que provoca que apenas esté en reposo. Evidentemente eso provoca un aumento del consumo y la temperatura del chip.

Hay otro gran consumidor de procesadores y circuitos integrados en general: la industria automovilística. Hasta ahora, las necesidades de procesamiento han sido bastante limitadas y en muchos de los sistemas de un vehículo, al igual que en servidores, el tiempo de reposo supera con mucho al tiempo de funcionamiento. Pero los coches autónomos van a cambiar la situación. Además, en un vehículo el reto es doble: por una parte la fiabilidad debe ser superior por razones evidentes y por otra el entorno en el que se encuentra el dispositivo va a tener temperaturas extremas con limitadas posibilidades de refrigeración. ¿Cómo se mantiene un SoC dentro de la temperatura de operación cuando el entorno está a 80ºC y no existe posibilidad de ventilación forzada?

Según una jefa de marketing de Helic (desarrollador de software EDA), estamos viendo una aceleración en el envejecimiento de los chips. Podrían estar perdiendo ciclos de reloj o haber errores extra. O podría haber roturas del dieléctrico. Esa afirmación reabre un tema que se ha considerado más bien poco riguroso desde el comienzo de los tiempos: un procesador podría perder potencia conforme pasan los años. La creencia popular es que algo así podría pasar si se hace overclock a una CPU y durante unos cuantos años la refrigeración es deficiente. La consecuencia sería tener que ir aumentando la tensión conforme pasa el tiempo para mantener la estabilidad. Sobre esto sigue habiendo opiniones en todos los sentidos. Pero el hecho de que hayamos llegado a nodos tan reducidos y que los chips funcionen en condiciones cada vez más extremas, parece que podría dar verosimilitud a tal afirmación.

Hasta ahora, la tendencia en los sistemas digitales ha sido disminuir el nivel de integración. La reducción del ancho de puerta ha sido gradual e imparable hasta nuestros días. Pero para ciertas aplicaciones, es posible que el futuro sea muy diferente a lo esperado, porque una de las formas de reducir los fallos físicos es precisamente aumentar el tamaño del dieléctrico, el sustrato y los cables.

Para los que se estén preguntando en qué afecta al común de los mortales, deben saber que desde que la evolución del hardware es dirigida por los grandes centros de datos y la industria más que por el usuario doméstico, si estos actores empiezan a demandar hardware con unas características determinadas, inevitablemente acabará afectado a todos los sectores.

Vía Semiconductor Engineering.